1VQ9がZeroMQで遊んでたので、俺も橋本商会 cvCalcOpticalFlowBMをZeroMQでpubしてみた。ZeroMQはなんか面倒な事を適当にやってくれるmessaging libraryで、色々な言語のバインディングが出ている。

ZeroMQのpubはセンサーのデータとかを垂れ流しにするのに都合がよさそう。

clientが何台いるかどうかを考えないで良いし、pub/subどちらが先に起動していても適当に接続処理をしてくれる。cookbookを見てるとmulticastやthread間通信にも使ってる。とりあえずセンサーデータ垂れ流しという用途に俺はよく使いそう。

ソースコードはgithubに置いた。

他にも単純なカウントアップのpub/sub両方をC++/C/Rubyで書いた(6種)のと、twitterのstream APIをZMQ_PUBで中継するのを作ってみた(解説:zeromqインストール、twitter stream APIを中継 – 橋本詳解)。特にstream APIのHUB的存在は便利。

あと、mongrel2がWebSocketやXMLSocketとZeroMQの接続をしてくれるようになるらしくて期待してる。

受信側

opticalflow_sub.rb

#!/usr/bin/env ruby

require 'rubygems'

require 'zmq'

ctx = ZMQ::Context.new

sock= ctx.socket(ZMQ::SUB)

sock.connect('tcp://127.0.0.1:5000')

sock.setsockopt(ZMQ::SUBSCRIBE, 'opticalflow')

loop do

puts sock.recv()

end

送信側。これを適当なパソンコにUSBカメラ刺して動かしておけば、別のマシンから動きが取れる!!

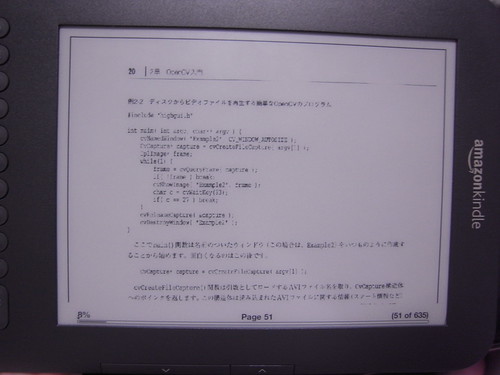

opticalflow_pub.cpp

// http://opencv.jp/sample/optical_flow.html

#include <cv.h>

#include <highgui.h>

#include <cxcore.h>

#include <ctype.h>

#include <stdio.h>

#include <iostream>

#include <boost/format.hpp>

#include <zmq.hpp>

using namespace std;

using namespace boost;

void detect_flow(IplImage *img, IplImage *img_p, IplImage *dst);

zmq::context_t ctx(1);

zmq::socket_t sock(ctx, ZMQ_PUB);

int main(int argc, char* argv[]) {

IplImage *img = NULL;

CvCapture *capture = NULL;

capture = cvCreateCameraCapture(0);

//capture = cvCaptureFromAVI("test.mov");

if(capture == NULL){

cerr << "capture device not found!!" << endl;

return -1;

}

sock.bind("tcp://127.0.0.1:5000");

CvSize size = cvSize(320, 240);

IplImage *img_resized = cvCreateImage(size, IPL_DEPTH_8U, 3);

IplImage *img_gray = cvCreateImage(size, IPL_DEPTH_8U, 1);

IplImage *img_gray_p = cvCreateImage(size, IPL_DEPTH_8U, 1);

IplImage *img_dst = cvCreateImage(size, IPL_DEPTH_8U, 3);

char winNameCapture[] = "Capture";

cvNamedWindow(winNameCapture, CV_WINDOW_AUTOSIZE);

while (1) {

img = cvQueryFrame(capture);

cvResize(img, img_resized);

cvCvtColor(img_resized, img_gray, CV_BGR2GRAY);

cvCopy(img_resized, img_dst);

detect_flow(img_gray, img_gray_p, img_dst);

cvShowImage(winNameCapture, img_dst);

cvCopy(img_gray, img_gray_p);

if (cvWaitKey(10) == 'q') break;

}

cvReleaseCapture(&capture);

cvDestroyWindow(winNameCapture);

return 0;

}

void detect_flow(IplImage *src_img1, IplImage *src_img2, IplImage *dst_img){

int i, j, dx, dy, rows, cols;

int block_size = 24;

int shift_size = 10;

CvMat *velx, *vely;

CvSize block = cvSize(block_size, block_size);

CvSize shift = cvSize(shift_size, shift_size);

CvSize max_range = cvSize(50, 50);

rows = int(ceil (double (src_img1->height) / block_size));

cols = int(ceil (double (src_img1->width) / block_size));

velx = cvCreateMat(rows, cols, CV_32FC1);

vely = cvCreateMat(rows, cols, CV_32FC1);

cvSetZero(velx);

cvSetZero(vely);

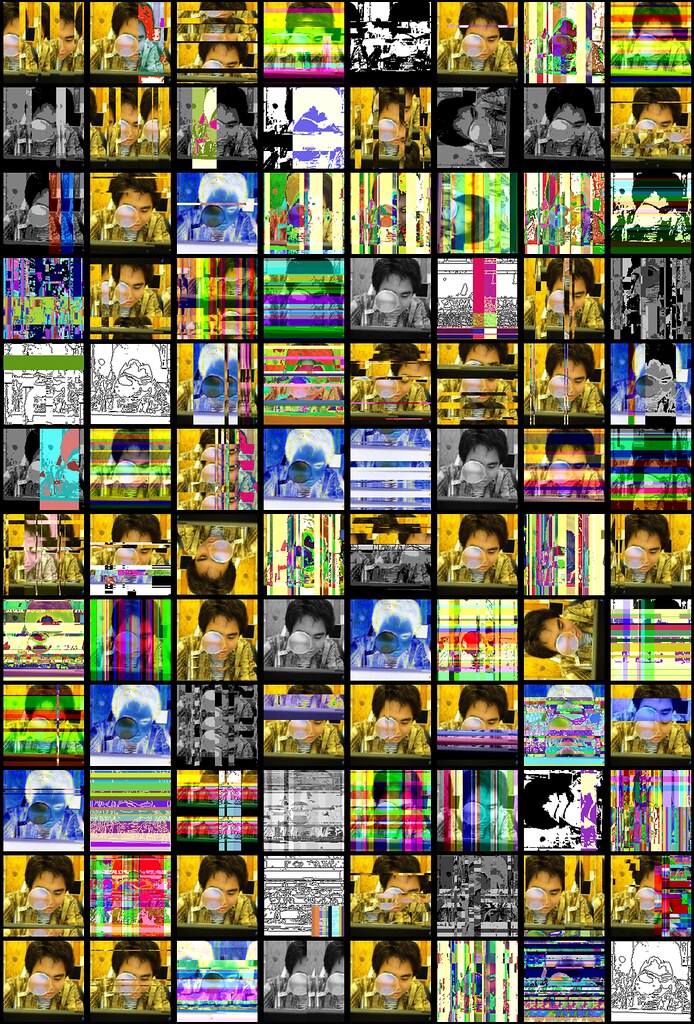

cvCalcOpticalFlowBM(src_img1, src_img2, block, shift, max_range, 0, velx, vely);

string result_str = string("");

for (i = 0; i < velx->width; i++) {

for (j = 0; j < vely->height; j++) {

dx = (int)cvGetReal2D(velx, j, i);

dy = (int)cvGetReal2D(vely, j, i);

cvLine(dst_img, cvPoint(i * block_size, j * block_size),

cvPoint(i * block_size + dx, j * block_size + dy), CV_RGB(255, 0, 0), 1, CV_AA, 0);

if(dx != 0 || dy != 0){

result_str += str(format("[%d,%d,%d,%d]") % (i*block_size) % (j*block_size) % dx % dy);

}

}

}

if(result_str.size() > 0){

result_str = str(format("opticalflow %s") % result_str);

cout << result_str << endl;

zmq::message_t msg(result_str.size()+1); // ZeroMQ

memcpy(msg.data(), result_str.c_str(), result_str.size()+1);

sock.send(msg);

}

}

g++ -O opticalflow_pub.cpp -o opticalflow_pub.bin -I/opt/local/include/opencv -lcv -lcvaux -lcxcore -lhighgui -I/usr/local/include /usr/local/lib/libzmq.a

これで動いた座標とその方向 [x,y,dx,dy] が連続で送られてくる。

opticalflow [48,216,4,-29][72,216,0,-29][96,216,0,-29][264,216,-9,-29]

opticalflow [48,216,4,-29][96,216,0,-29][120,216,0,-29][264,216,-9,-29]

opticalflow [48,216,4,-29][96,168,0,10][96,192,-10,-20][96,216,0,-29][120,192,0,10][120,216,0,-29][144,216,0,-29][168,216,0,-29][192,48,-10,0][192,216,0,-29][216,216,0,-29][264,216,-9,-29]

opticalflow [96,168,0,10][96,192,-10,-10][96,216,0,-29][120,168,0,10][120,192,0,10][120,216,0,-29][144,216,0,-29][168,48,0,10][168,96,0,10][168,216,0,-29][192,72,0,40][192,96,0,-30][192,216,0,-29][264,216,-9,-29]

opticalflow [48,216,4,-29][96,168,0,10][96,216,0,-29][120,168,0,10][120,192,0,10][120,216,0,-29][144,216,0,-29][168,48,10,0][168,96,0,10][168,216,0,-29][192,96,0,-30][192,216,0,-29][264,216,-9,-29]