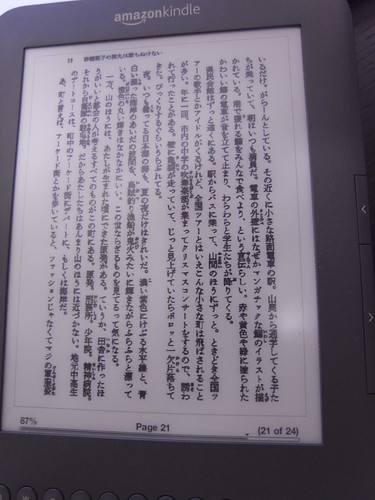

橋本商会 scansnapで自炊した本をkindleで読めるように補正するをOpenCV使ってC++で書き直したら60倍速くなった。635ページのオライリーの本が約1分半で処理できたし、画質も前のJRuby版より少し読みやすくなった気がする。

こういう事をする。

■やっている事

scansnapで自炊した本をそのままkindleで表示するには色々問題がある。

- kindleの解像度は800×600だけど、画面内にページ位置等のUIが入るし画面を縦横回転させたり拡大縮小できるので、表示時にkindle上でリサイズされる。この時、線が細くて薄い部分が消滅してしまって、文字がかすれて読めなくなってしまう。

- scansnapで取り込んだままのPDFファイルでは、コントラストが弱くてとても読みづらい。

- ページの上下左右の余白が邪魔で、kindleに全画面表示した時に小さくなってしまう

kindle上でリサイズされる事を前提として、文字が消えてしまうような細い部分を太くしてやるしかない。

しょうがないので、コントラストを上げたり、拡大縮小されるのを前提として先にアンチエイリアス?的な処理をしたり、余白を切り取ったり、リサイズしたりするようにした。

上下左右を裁ち落とし→リサイズ→グレースケール化→2値化→黒の周りを#999999で太らせるという処理をしている。

上下左右裁ち落とし→グレースケール化→2値化→黒の周りを#000000で太らせる→リサイズ

という処理に変えた。JRuby+javax.imageioでピクセル単位に処理すると、解像度が大きい画像を処理するのが苦しかったので先にリサイズするようにしていた。

OpenCVは十分速いので、高解像度のまま処理して最後に縮小するように変更した。これでサイズが大きい本でも綺麗に変換できる。

■使う

OpenCV1.00以上と、boostのboost::system, boost::filesystem, boost::program_optionsのインストールが必要。少なくともMacとUbuntuでは動く。

その辺はgithub/shokai/scansnap_adjust_images_kindleに書いた。

gitリポジトリを持ってきてコンパイルする

git clone git://github.com/shokai/scansnap_adjust_images_kindle.git

cd scansnap_adjust_images_kindle/kindlize_images

# for Mac

make -f Makefile.macosx

./configureの作り方がよくわからないのでとりあえずMac用のMakefileだけ置いてある。

Linuxとかでも、opencv、boost::filesystem、boost::progoram_optionsをインストールしてあればコンパイルはできる。(この組み合わせは色々なOSでよく使ってる)

オライリーの判型の本をkindle用に補正する。上下左右の余白を削除して白黒になって文字が太くなる。イラストは見づらくなるかもしれない。

mkdir ~/tmp/mybook_kindle

./kindlize_images --help

./kindlize_images -i ~/tmp/mybook/ -o ~/tmp/mybook_kindle/ -t 190 -w 1200 -h 1600 --cleft 120 --cright 120 --ctop 150 --cbottom 150

はじめにPDFから連番のJPEG画像に書き出して、それからこのツールを使って変換して、最後に連番画像をPDFにまとめるという使い方を想定している。

PDFから連番画像を書き出す方法は、前の記事やgithubのREADME.mdに書いた。

連番画像を1つのPDFへ結合するのは、gitリポジトリの中に一緒にimages2pdf.appというautomatorアプリを入れて置いたのでそれを使うと良い。

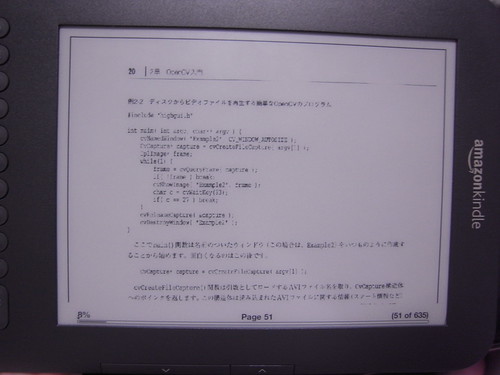

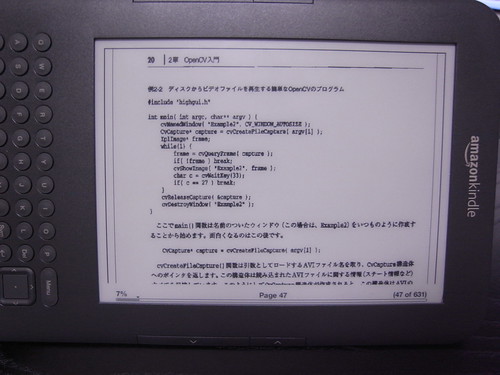

■ソースコード

100行切った。boost::filesystemのおかげでディレクトリ内一括処理が書きやすかった。

JRuby使って書くよりもコードが35行短くなったけど、最初に試行錯誤するにはJRuby+javax.imageioでやる方が手軽だったな。

kindlize_images/kindlize_images.cpp at master from shokai's scansnap_adjust_images_kindle – GitHub

#include "cv.h"

#include "highgui.h"

#include <boost/program_options.hpp>

#include <boost/filesystem/operations.hpp>

#include <boost/filesystem/path.hpp>

#include <boost/filesystem/fstream.hpp>

#include <iostream>

using namespace boost;

using namespace std;

namespace fs = boost::filesystem;

IplImage *adjust_image(IplImage *img, program_options::variables_map argmap){

int cleft = argmap["cleft"].as<int>();

int cright = argmap["cright"].as<int>();

int ctop = argmap["ctop"].as<int>();

int cbottom = argmap["cbottom"].as<int>();

const int w = img->width - cleft - cright;

const int h = img->height - ctop - cbottom;

cvSetImageROI(img, cvRect(cleft, ctop, w, h));

IplImage *img_gray = cvCreateImage(cvSize(w,h), IPL_DEPTH_8U, 1);

cvCvtColor(img, img_gray, CV_BGR2GRAY);

// 2値化

IplImage *img_bin = cvCreateImage(cvSize(w,h), IPL_DEPTH_8U, 1);

cvThreshold(img_gray, img_bin, argmap["threshold"].as<int>(), 255, CV_THRESH_BINARY);

// 文字を太らせる

cvErode(img_bin, img_bin, NULL, 1);

// リサイズ

int width = argmap["width"].as<int>();

int height = argmap["height"].as<int>();

IplImage *img_resized;

double scale = ((double)h)/w;

if(((double)height)/width < scale){ // 縦長

img_resized = cvCreateImage(cvSize((int)(height/scale), height), IPL_DEPTH_8U, 1);

}

else{ // 横長

img_resized = cvCreateImage(cvSize(width, (int)(scale*width)), IPL_DEPTH_8U, 1);

}

cvResize(img_bin, img_resized, CV_INTER_LINEAR);

cvReleaseImage(&img_bin);

cvReleaseImage(&img_gray);

return img_resized;

}

int main(int argc, char* argv[]) {

program_options::options_description opts("options");

opts.add_options()

("help", "ヘルプを表示")

("width,w", program_options::value<int>(), "output width")

("height,h", program_options::value<int>(), "output height")

("threshold,t", program_options::value<int>(), "binarize threshold")

("input,i", program_options::value<string>(), "input directory name")

("output,o", program_options::value<string>(), "output directory name")

("cleft", program_options::value<int>(), "crop left (pixel)")

("cright", program_options::value<int>(), "crop right (pixel)")

("ctop", program_options::value<int>(), "crop top (pixel)")

("cbottom", program_options::value<int>(), "crop bottom (pixel)");

program_options::variables_map argmap;

program_options::store(parse_command_line(argc, argv, opts), argmap);

program_options::notify(argmap);

if (argmap.count("help") || !argmap.count("input") || !argmap.count("output") ||

!argmap.count("threshold")) {

cerr << "[input, output] required" << endl;

cerr << opts << endl;

return 1;

}

string in_dir = argmap["input"].as<string>();

fs::path path = complete(fs::path(in_dir, fs::native));

fs::directory_iterator end;

for (fs::directory_iterator i(path); i!=end; i++){

string img_fullname = in_dir + i->leaf();

cout << img_fullname << endl;

IplImage *img, *img_result;

img = cvLoadImage(img_fullname.c_str());

if(!img){

cerr << "image file load error" << endl;

}

else{

img_result = adjust_image(img, argmap);

string out_filename = argmap["output"].as<string>() + "/" + i->leaf();

cvSaveImage(out_filename.c_str(), img_result);

cvReleaseImage(&img);

cvReleaseImage(&img_result);

}

}

}